Dedizierte Server in Europa vs. Hyperscaler. Lohnt sich das noch, oder ist es nur eine andere Kostenkurve?

TL;DR

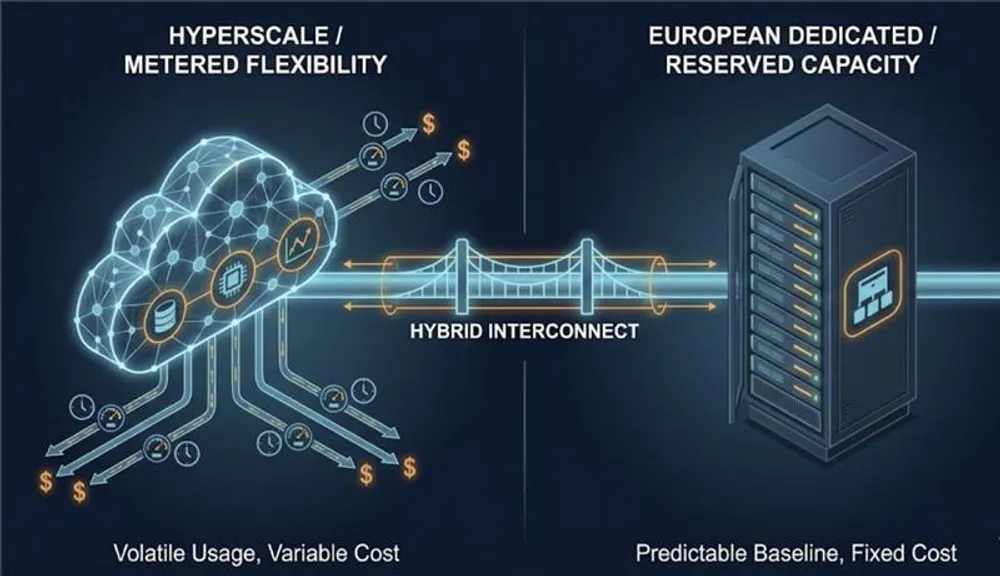

- Die echte Entscheidung ist nicht „Cloud vs. Dedicated“. Es sind gemessene Kosten versus reservierte Kapazität.

- Cloud ist stark, wenn Nachfrage unsicher ist, stark schwankt, oder wenn du auf Managed Services angewiesen bist.

- Dedizierte Server in Europa sind stark, wenn Workloads schwer, dauerhaft und netzwerkintensiv sind, und du Cloud-ähnliche Planbarkeit willst, ohne dutzende Zähler.

- Performance-Schwankungen und IP-Reputation sind echte Gründe, sich von Shared VPS und bestimmten Public-Cloud-IP-Ranges zu lösen.

- Hybride Infrastruktur ist normal, weil die meisten Systeme gemischte Workload-Formen haben. Richtig umgesetzt ist es kein Kompromiss. Es ist Portfoliomanagement.

Cloud vs. Dedicated in Europa ist die falsche Debatte. Die echte Frage ist die Kostenkurve.

Diese Debatte kommt in Infrastrukturkreisen immer wieder zurück, weil die Trade-offs real sind.

Nicht weil Engineers nostalgisch auf Hardware schauen. Nicht weil jemand Hyperscaler „schlagen“ will. Sie kommt zurück, weil sich Kostenkurven, Performancekurven und operativer Aufwand je nach Setup fundamental anders verhalten.

Also stell die richtige Frage.

Die Marketingversion lautet „Cloud vs. Dedicated“.

Die Engineeringversion lautet:

Willst du Infrastrukturkosten, die mit der Nutzung mitgehen, oder Infrastrukturkosten, die an reservierte Kapazität gebunden sind?

Wenn du so denkst, wird es weniger emotional und deutlich nützlicher. Menschen streiten nicht über Ideologie. Sie streiten über Unit Economics, Risiko und die tägliche Realität beim Betrieb von Systemen.

Cloud gewinnt oft bei Elastizität, Geschwindigkeit und Managed Services.

Dedicated gewinnt oft bei vorhersehbarer Performance und vorhersehbaren Kosten bei dauerhaft hohen Workloads.

Die meisten erfahrenen Teams landen in der Mitte. Hybride Infrastruktur ist keine Unentschlossenheit. Es ist eine rationale Antwort darauf, wie moderne Systeme wirklich aussehen.

Dieser Beitrag zerlegt die Trade-offs ruhig und sachlich. Keine Panikmache. Keine Absolutismen. Keine vagen Marketingphrasen.

Warum diese Frage immer wieder auftaucht

Das Muster ist vorhersehbar.

Du startest in der Public Cloud, weil es schnell geht. Es gibt Credits. Provisioning ist einfach. Du kannst liefern, ohne über Hardware-Beschaffung oder Kapazitätsplanung nachzudenken.

Dann schlägt einer der typischen Trigger zu.

Trigger 1: Der Workload ist nicht mehr „bursty“

Viele Produkte starten spiky und werden später stabil.

Am Anfang ist die Nutzung unregelmäßig. Autoscaling hilft. Kosten fühlen sich okay an, weil du bei „nichts passiert“ auch kaum zahlst.

Dann stabilisiert sich der Workload und wächst. AI-Inference läuft Tag und Nacht. Datenverarbeitung wird zu einer täglichen oder kontinuierlichen Pipeline. APIs werden konstant. Indexing hört nicht auf. CI-Runner laufen dauerhaft.

Ab da kaufst du nicht mehr Elastizität. Du mietest Kapazität permanent.

Und genau da kippt die Ökonomie.

Trigger 2: Netzwerkkosten werden der größte Posten

Viele Teams schauen auf VM-Preise und werden dann vom Netzwerkmodell überrascht.

Wenn dein Produkt Daten nach außen schiebt, zu Usern, Partnern oder anderen Systemen, wird Outbound Traffic ein erstklassiger Kostentreiber. Dazu gehören Medien, Datensätze, Downloads, API-Payloads und Off-Platform-Backups.

Cloud-Egress ist keine Randnotiz. Es ist eine Preisdimension, für die du designen musst.

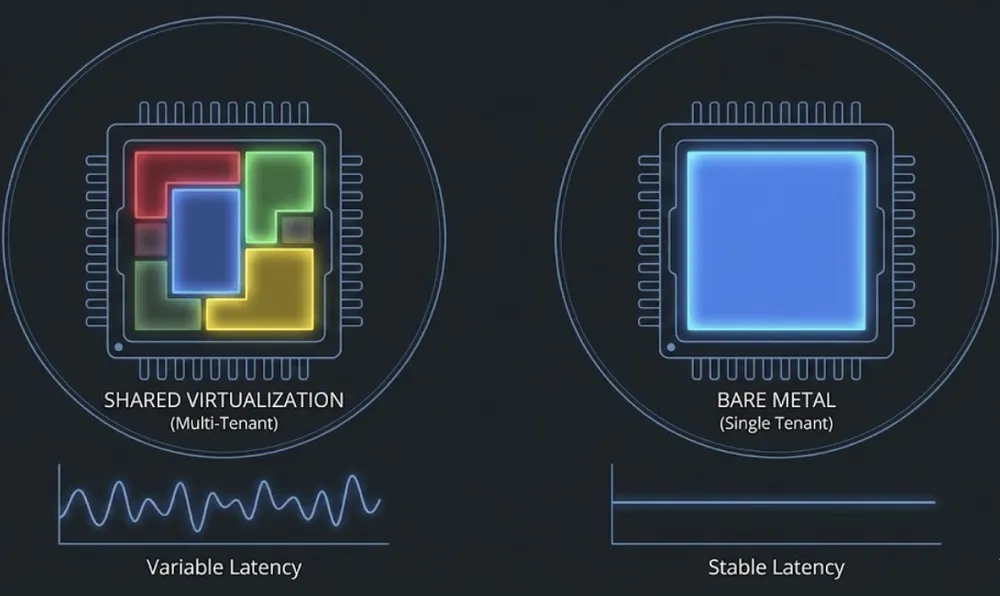

Trigger 3: Performance wird inkonsistent

Das ist der frustrierendste Trigger, weil er sich zufällig anfühlt.

Monatelang ist alles gut. Dann driftet die Latenz. CPU-Performance schwankt. Disk-Throughput stößt an Grenzen. Netzwerkdurchsatz wird unvorhersehbar. Eine „Fair Use“-Grenze wird sichtbar.

Das ist kein Versagen der Cloud. Multi-Tenant-Virtualisierung hat Trade-offs. Shared Storage hat Trade-offs. Overcommit-Ratios existieren. Contention existiert.

Manche Workloads tolerieren Varianz. Andere nicht.

Trigger 4: IP-Reputation erzeugt operativen Schmerz

Unsexy, aber real.

Manche Teams gehen weg von Shared VPS und Cloud-IP-Ranges, weil E-Mail-Deliverability zur Dauerbaustelle wird, oder weil pauschale Blocks bestimmter Ranges bei Enterprise-Kunden zu Reachability-Problemen führen.

Dann ist die Lösung nicht „besseres Autoscaling“. Dann ist die Lösung ein anderes IP-Reputationsprofil. Und das bedeutet oft eine andere Infrastrukturklasse.

Diese Trigger erklären, warum das Thema so präsent bleibt. Die Entscheidung ist selten philosophisch. Sie ist praktisch.

Warum sich Kosten in Cloud und Dedicated anders verhalten

Die einfachste Erklärung für „Bare Metal vs. Cloud“ ist: Was kaufst du tatsächlich?

Public Cloud ist im Kern ein Set von Zählern.

Dedicated ist meist ein gebündeltes Kapazitäts-Paket.

Cloud-Kosten sind über viele Dimensionen gemessen

In Public Cloud wird vieles nach Verbrauch abgerechnet:

- Compute pro Sekunde, Minute oder Stunde.

- Storage pro GB-Monat.

- IOPS und Throughput in manchen Storage-Tiers.

- Load Balancing pro Stunde und nach Nutzungsdimensionen.

- Managed Datenbanken nach Instanzgröße, Storage und teilweise I/O.

- Network Egress pro GB.

- Cross-Zone- und Cross-Region-Traffic pro GB.

Selbst wenn du Compute über Commitments rabattierst, laufen weiter mehrere Zähler parallel.

Die Rechnung wird damit eine Funktion aus Nutzung, Architekturentscheidungen und Fehlern.

Dedicated-Kosten sind gebündelt

Bei dedizierten Servern kaufst du typischerweise einen festen Pool:

- Fixes CPU- und RAM-Budget.

- Ein Storage-Profil, oft lokale Disks.

- Eine Portgeschwindigkeit.

- Ein Bandwidth-Bundle oder „unmetered“ mit Fair Use.

- IPs inklusive oder pro IP berechnet.

- Optionale Add-ons wie Backup, Private Networking oder DDoS-Mitigation.

Deine Rechnung wird zur Funktion dessen, was du upfront reservierst.

Du zahlst nicht für jedes kleine Event im System. Du zahlst für Kapazität.

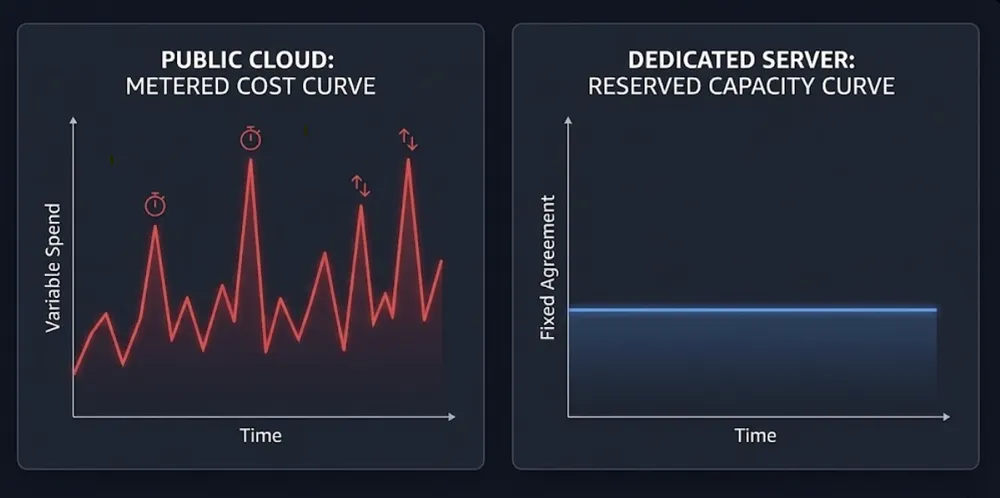

Das Baseline-Problem ist der Kern

Cloud ist finanziell effizient, wenn deine Baseline niedrig ist und deine Peaks hoch sind.

Dedicated wird finanziell effizient, wenn deine Baseline hoch und stabil ist.

Wenn du 10 Prozent CPU die meiste Zeit nutzt und zweimal am Tag hart spikest, passt Cloud oft gut. Du skalierst hoch und runter und hörst auf zu zahlen.

Wenn du 70 bis 90 Prozent CPU den ganzen Tag, jeden Tag nutzt, kann Cloud teuer werden, weil du Peak-Kapazität permanent mietest. Du zahlst Marge auf jede Stunde dauerhafter Nutzung.

Deshalb tauchen AI-Workloads so oft auf. Viele AI-Workloads sind nicht bursty. Sie sind Fabriken.

Egress ist keine Fußnote

Wenn dein Produkt Daten aus der Plattform bewegt, kann Outbound Traffic Compute-Kosten überholen. Cross-Zone-Traffic kann ebenfalls relevant werden, wenn du für Redundanz verteilst, ohne das Netzwerkverhalten zu modellieren.

Das heißt nicht, dass Cloud immer teuer ist. Es heißt, dass die Kostenkurve steil werden kann, wenn Datenbewegung Teil des Produkts ist.

Dedicated hat oft eine flachere Netzwerk-Kostenkurve. Es gibt weiterhin Limits, und „unmetered“ braucht weiterhin eine faire Policy. Aber die Rechnung ist oft weniger empfindlich gegenüber internen Architekturdetails wie Cross-Zone-Flows.

Genau deshalb wirkt Cloud-Kostenplanung in der Praxis oft schwer. Je mehr Zähler du hast, desto mehr Leckstellen für Spend.

Managed Services verschieben den Vergleich

Wenn du „VM-Preis vs. Server-Preis“ vergleichst, verfehlst du oft den Punkt.

Cloud verkauft Zeit.

Managed Datenbanken, Queues, Caches, Identity und Observability reduzieren operativen Aufwand. Sie können die Notwendigkeit eines eigenen Plattformteams verringern.

Wenn du stark auf Managed Services setzt, kann Cloud netto gewinnen, auch wenn Raw Compute teurer ist. Du kaufst weniger Engineering-Stunden, oder vermeidest Projekte, die du nicht staffen kannst.

Wenn du ohnehin überwiegend self-managed fährst, schrumpft dieser Vorteil. Dann dominieren Raw Compute und Netzwerkökonomie.

Performance-Konsistenz und warum sie entscheidend wird

Cloud-Performance-Probleme sind oft intermittent. Genau deshalb sind sie schwer zu akzeptieren.

Eine Woche ist alles gut. Dann kommt Latenz-Jitter. CPU-Performance variiert. Disk-Throughput ändert sich. Netzwerkdurchsatz wird unvorhersehbar. Ein Nachbar ist laut. Throttling taucht an Stellen auf, die du nicht modelliert hast.

Das ist Multi-Tenancy und Abstraktion.

Dedizierte Server entfernen eine große Variable:

- Du besitzt den gesamten Host.

- Du vermeidest host-level „noisy neighbors“.

- Du kannst CPU-Pinning, NUMA, Hugepages und Kernel-Verhalten tunen, wenn nötig.

- Du bekommst oft besser planbaren Durchsatz.

Darum taucht Dedicated immer wieder bei High-Performance-Compute und High-Throughput-Networking auf.

Der Trade-off bleibt real.

Dedicated gibt dir nicht automatisch Resilienz. Wenn du Multi-Zone-Redundanz brauchst, designst du sie. Wenn du sofortige Kapazität brauchst, hältst du Reserve oder akzeptierst langsamere Provisionierung.

Die echte Abwägung ist Kontrolle und Stabilität versus Elastizität und Convenience.

IP-Reputation und E-Mail-Deliverability

Das Thema wirkt unwichtig, bis es dein Incident ist.

Manche Teams gehen weg von Shared VPS und Cloud-Ranges, weil Deliverability zum Dauerkrieg wird. Pauschale Range-Blocks passieren. Aggressive Blocklists existieren. Legitime Mails landen im Spam. Manche Ziele sind für Enterprise-User mit strikten Filtern praktisch nicht erreichbar.

Dedicated kann helfen, weil du oft eine „sauberere“ IP-Historie bekommst oder eine besser kontrollierbare Range.

Aber es ist kein Allheilmittel.

Deliverability hängt heute stark von SPF, DKIM, DMARC, Sending Patterns und Reputation ab. Eine saubere IP hilft, ersetzt aber kein Know-how. Für viele Businesses bleibt Outsourcing von E-Mail rational.

Die größere Lektion ist breiter.

Infrastrukturentscheidungen werden manchmal durch Edge-Constraints getrieben, nicht durch CPU-Preis. IP-Reputation ist so ein Constraint.

DDoS-Schutz ist nicht exklusiv Cloud

Es gibt eine verbreitete Annahme, DDoS-Mitigation sei „ein Public-Cloud-Ding“. Ist es nicht.

Hyperscaler haben riesige Netzwerke und reife Fähigkeiten. Das kann, je nach Threat Model, ein echter Vorteil sein.

Aber auch Dedicated- und europäische Infrastrukturprovider bieten DDoS-Mitigation, oft direkt in ihr eigenes Netzwerk integriert.

Der Unterschied ist meist nicht, ob Mitigation existiert. Der Unterschied ist Abdeckung, Skalierung, Integrationsaufwand, Reaktionszeit und Preis.

Wenn DDoS für dein Business relevant ist, behandle es als Requirement und stelle konkrete Fragen zu Coverage und Verhalten während Angriffen.

Virtualisierung auf Bare Metal ist ein echter Mittelweg

Ein weiterer überholter Gedanke ist, dass Dedicated „manuell“ und „unflexibel“ bedeutet.

Du kannst Virtualisierung oder Private-Cloud-Stacks auf dedizierter Hardware betreiben:

- VMware für reife Virtualisierung.

- OpenStack für Private-Cloud-Primitives.

- OpenNebula für ein einfacheres VM-Cloud-Modell.

- Kubernetes auf Bare Metal für Container-Workloads mit Substrate-Kontrolle.

Mit sauberem Provisioning und Automation kann Bare Metal im Alltag cloud-ähnlich wirken.

Die ehrliche Grenze ist nicht Technik. Es ist Scope.

Eine gute interne Plattform zu bauen kostet Skill, Zeit und Disziplin. Für kleine Teams kann der Human Cost die Einsparung auffressen. Für starke Teams mit stabilen Workloads kann es ein Wettbewerbsvorteil sein.

Wann dedizierte Server in Europa Sinn ergeben

Dedicated ist nicht „immer günstiger“.

Dedicated ist oft flacher.

Dedizierte Server in Europa passen gut, wenn dein Workload Eigenschaften wie diese hat.

Dauerhaft hohe Compute-Last

AI-Inference, die konstant läuft. CPU-bound Processing. Stetige High-QPS-APIs. Encoding, Indexing, Pipelines.

Wenn die Auslastung konstant hoch ist, verbessert sich die Dedicated-Ökonomie, weil du für eine Box zahlst, die du wirklich nutzt.

Hoher oder gut planbarer Outbound Traffic

Wenn dein Produkt Daten ausliefert, kann Cloud-Egress die Kosten dominieren. Dedicated bietet oft stabilere Netzwerkpreise. Das verbessert Forecasting.

Performance-Sensitivität

Wenn du Jitter, stabilen Durchsatz, konsistente Disk-I/O oder hohe Packet Rates brauchst, reduziert Dedicated host-level Varianz.

Kontrolle über die Substrate

Wenn du Kernel-Tuning, CPU-Pinning, NUMA-Awareness, Hugepages oder GPU-Passthrough brauchst, gibt dir Dedicated Optionen, die in Multi-Tenant-Umgebungen schwerer zu garantieren sind.

Weniger Billing-Überraschungen

Metered Systeme bestrafen Blind Spots. Dedicated vereinfacht Forecasting, weil Kapazität fix ist.

Es entfernt nicht die operative Verantwortung. Es reduziert die Anzahl der Zähler, die dich überraschen können.

Wann dedizierte Server in Europa keinen Sinn ergeben

Dedicated ist in vielen Fällen das falsche Tool.

Spiky Workloads und unsichere Nachfrage

Wenn Nachfrage unsicher ist, ist bezahlte Idle-Kapazität Verschwendung. Cloud-Elastizität ist oft der richtige Default.

Starke Abhängigkeit von Managed Services

Wenn deine Architektur auf Managed Datenbanken, Queues, Serverless oder Provider-native Analytics angewiesen ist, wird ein Umzug schnell zum Rewrite. Manchmal gerechtfertigt. Oft nicht.

Anforderungen an globale Distribution

Wenn du schnell Multi-Region-Präsenz brauchst, haben Hyperscaler strukturelle Vorteile. Global auf europäischer Infrastruktur zu bauen geht auch, erfordert aber mehr Design-Aufwand.

Kleine Teams ohne Plattform-Kapazität

Dedicated verschiebt Verantwortung zu dir. Patching, Monitoring, Backups, HA-Design und Incident Response verschwinden nicht.

Wenn du es nicht staffen kannst, ist Cloud keine Faulheit. Es ist Fokus.

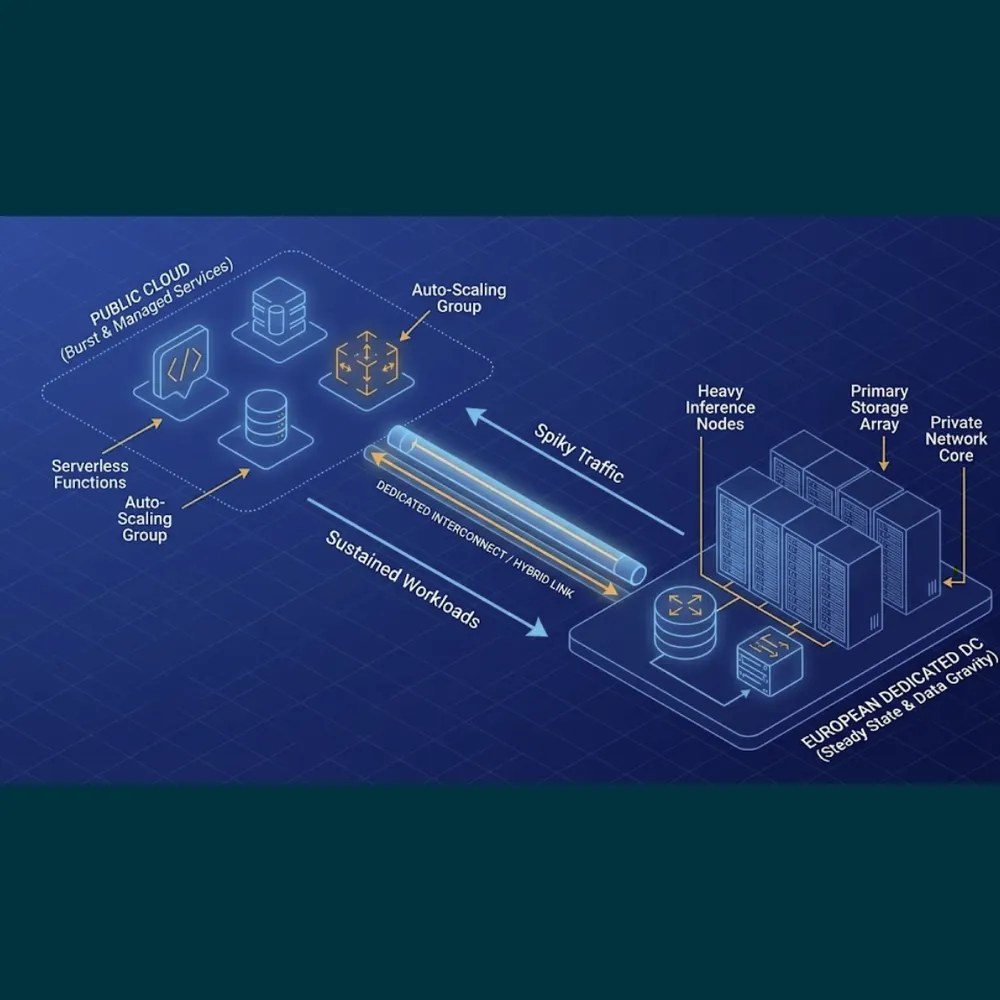

Hybride Infrastruktur ist normal, weil sie der Realität entspricht

Die meisten Systeme haben nicht nur eine Workload-Form. Du hast meist eine Mischung:

- Eine stabile Baseline.

- Bursts durch Batch, Launches oder Saisonalität.

- Sticky State und portable stateless Services.

- Constraints, wo Daten liegen dürfen.

- Constraints bei Latenz und Geografie.

Hybride Infrastruktur erlaubt dir, jede Komponente dort zu platzieren, wo sie am besten passt.

Darum ist „it depends“ oft die korrekteste Antwort.

Pattern 1: Baseline auf Dedicated, Burst in Cloud

Stetige Compute-Last auf Dedicated. Cloud für Overflow, Experimente und kurzlebige Workloads.

Risiko: schlechtes Dataflow-Design. Wenn Burst-Jobs ständig Daten aus der Cloud ziehen oder zurückdrücken, frisst Netzwerk den Vorteil.

Pattern 2: State auf Dedicated, Stateless in Cloud

Datenbanken und datenintensive Systeme auf Dedicated für Planbarkeit. Stateless Services in der Cloud für schnelle Skalierung.

Funktioniert gut, wenn du Latenz und Traffic korrekt modellierst.

Pattern 3: Managed Control Plane in Cloud, Worker auf Dedicated

Cloud-Managed Services dort, wo sie Zeit sparen. Worker-Pools auf Dedicated, wo sustained Compute flacher ist.

Häufig bei Processing- und AI-Pipelines. Risiko: Netzwerk und Latenz ignorieren.

Pattern 4: Dedicated Primary, Cloud für Monitoring und DR-Staging

Produktion auf Dedicated. Kleine Cloud-Instanzen für Monitoring, externe Checks und Disaster-Recovery-Staging.

Das reduziert Blast Radius. DR ist nicht real, bis du es geübt hast.

Hybrid ist nicht kostenlos. Es gibt dir Wahlfreiheit und mehr Angriffs- und Betriebsflächen. Absichtlich gebaut ist es oft die defensibelste Architektur für gemischte Workloads.

Datensouveränität und EU-Eigentum, ohne Slogans

Behandle Datensouveränität als Requirements, nicht als Debatte.

Meist läuft es auf vier praktische Fragen hinaus:

1. Data Residency. Wo werden Daten gespeichert und verarbeitet?

2. Operative Kontrolle. Wer betreibt Infrastruktur und Support, und wo?

3. Jurisdiktion. Welche Gesetze können Zugriff erzwingen?

4. Vertragliche Klarheit. Was sagen die Terms zu Zugriff und Auditierbarkeit?

Dedizierte Server in Europa können bei Residency und operativer Kontrolle helfen. Europäische Provider ebenfalls. Hyperscaler bieten EU-Regionen, und für viele Workloads reicht das aus.

Ownership und Jurisdiktion sind für manche Organisationen relevant. Nicht für alle. Mach es nur dann zum Requirement, wenn es in dein Risk Model oder in Customer Demand fällt.

Ein Entscheidungsframework, das du vertreten kannst

Hör auf, „Cloud vs. Dedicated“ zu diskutieren. Entscheide nach Constraints.

Wähle Cloud zuerst, wenn

- Nachfrage unsicher oder spiky ist.

- du Managed Services brauchst, um schnell zu liefern.

- du schnell skalieren willst mit wenig operational overhead.

- variable monatliche Ausgaben für Speed okay sind.

Wähle Dedicated zuerst, wenn

- der Workload schwer und dauerhaft ist.

- du stabile Performance und Throughput brauchst.

- Egress und Netzwerk große Kostentreiber sind.

- du einfacheres Forecasting und weniger Meter willst.

- du es sauber betreiben kannst.

Wähle Hybrid, wenn

- dein System sowohl stabile als auch bursty Teile hat.

- du Managed Services willst, ohne Hyperscaler-Raten für alle Compute zu zahlen.

- Data Gravity und Compute Demand an unterschiedlichen Orten sitzen.

- du langfristig Freedom of Choice willst.

Wo Worldstream reinpasst

Worldstream bleibt bewusst fokussiert.

Wir liefern Infrastruktur. Bare Metal, Private Cloud und skalierbare Cloud-Infrastruktur.

Wir betreiben unsere eigenen Rechenzentren und unser eigenes Netzwerk in den Niederlanden. Wir bauen mit In-house-Engineering. Ziel sind planbare Vereinbarungen, planbare Preise, Freedom of Choice und kein Lock-in by Design.

Das ist Solid IT. No Surprises.

Das ist kein Argument gegen Hyperscaler. Sie lösen echte Probleme, besonders wenn Elastizität und Managed Services Priorität haben.

Es ist ein Argument dafür, Infrastruktur nach Workload-Realität zu wählen und Optionen offen zu halten.

Fazit: Wähle keine Teams. Wähle Constraints.

Also, lohnen sich dedizierte Server in Europa noch?

Ja, wenn der Workload dauerhaft ist, performance-sensitiv, netzwerkintensiv, oder wenn Forecasting langweilig und zuverlässig sein muss.

Nein, wenn dein Wert aus Elastizität, Managed Services und schneller Skalierung kommt, und wenn dein Team sich Plattformarbeit nicht leisten kann.

Meistens ist die beste Antwort Hybrid, bewusst designt.

Nicht als chaotischer Kompromiss.

Sondern als Weg, jeden Workload dem passenden Kostenmodell, dem passenden Betriebsaufwand und dem passenden Risikoprofil zuzuordnen.

Freedom of Choice schlägt Dogma. Jedes Mal.

FAQs

Manchmal, vor allem bei dauerhaft hoher Auslastung oder signifikantem Outbound Traffic. Cloud kann günstiger sein bei spiky Nachfrage und wenn Managed Services operative Kosten reduzieren. Die Kostenkurve hängt von Baseline-Nutzung und Datenbewegung ab.